曝OpenAI新旗艦模型“難產”,或明年年初發布

鳳凰科技 2024-11-12 01:35:05 2

編譯 | 汪越

編輯 | Panken

智東西11月11日訊息,據The Information報道,OpenAI的GPT系列模型改進速度放緩,公司正調整策略以應對這一挑戰。據OpenAI員工透露,下一代旗艦模型Orion已完成約20%的訓練。Orion在語言任務上表現出色,但在編碼等方面未超越GPT-4,且執行成本偏高,提升幅度低於預期。此外,Orion在明年年初發布時,可能不會沿用傳統的“GPT”命名規則,而是採用新的命名方式。

Orion的開發暴露了高質量文字資料短缺的問題。根據Scaling Law理論,模型效能應隨資料量和算力的增加而提升。但高質量資料的有限性已使Orion的訓練效果受限,令Scaling Law的適用性受到質疑。即便投入更多資料和算力,模型的提升速度也可能不再如前幾代那樣顯著。

為此,OpenAI成立了一個專門團隊,研究如何克服資料短缺的挑戰,評估Scaling Law還能適用多久。

一、撞上資料牆,Orion在某些方面神似舊模型

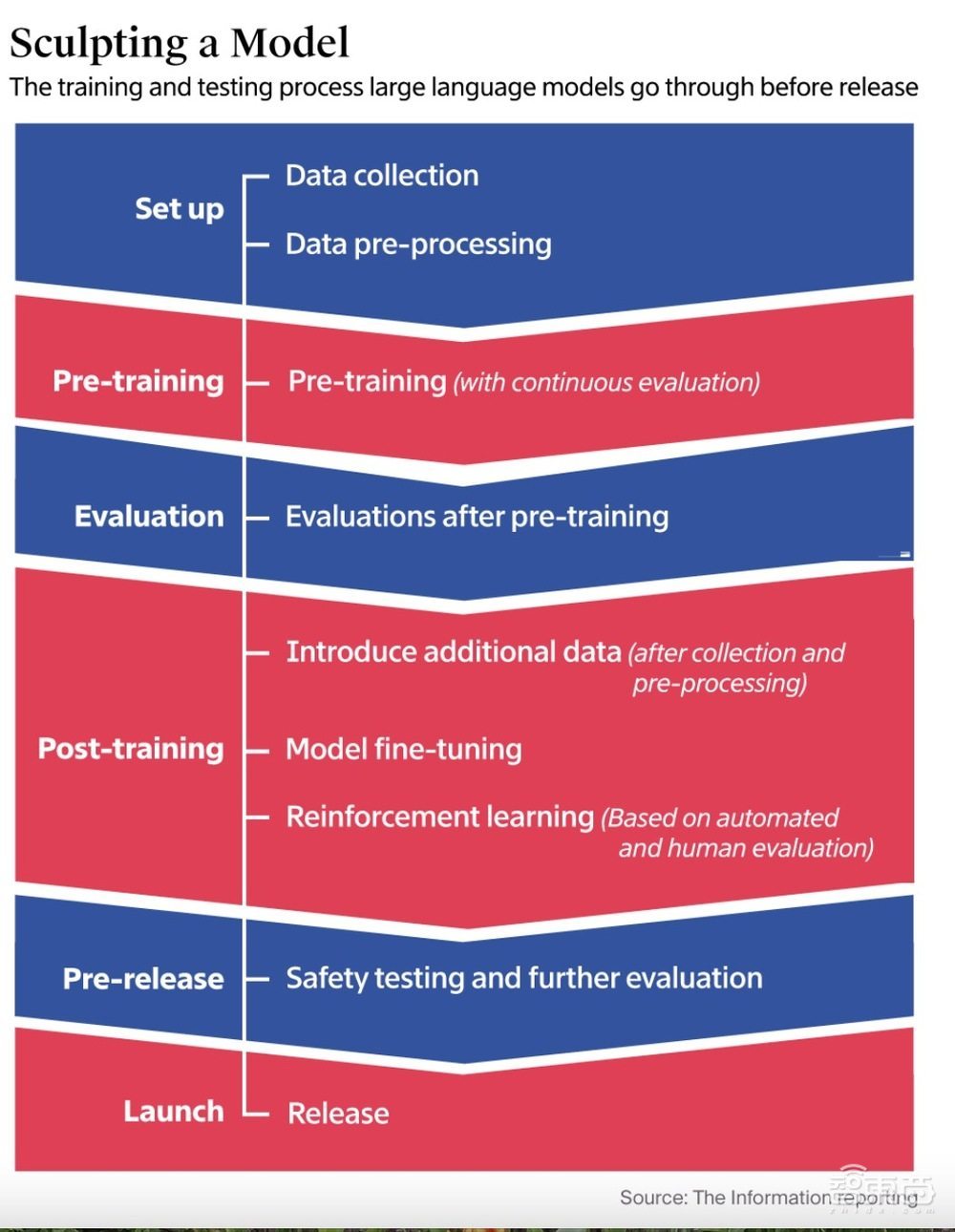

據OpenAI員工透露,GPT改進速度放緩的重要原因是高質量文字和其他資料的短缺。大語言模型(LLM)的預訓練需要大量資料來建立模型對世界和概念的理解,確保其能完成寫作或程式設計等任務。然而,隨著現有資料來源日益被充分利用,模型提升正面臨瓶頸。

▲LLM釋出前的訓練和測試過程(圖源:The Information)

為解決資料不足的問題,OpenAI已組建由前預訓練負責人尼克·萊德(Nick Ryder)領導的團隊,致力於探索如何克服資料短缺以及Scaling Law在未來的適用性。

Orion模型的部分訓練資料來源於AI生成的資料,即由GPT-4等舊模型生成的合成資料。然而,這種方式可能導致Orion在某些方面呈現出舊模型的特徵。

OpenAI正透過其他方法最佳化LLM處理任務的能力,例如要求模型從大量數學或程式設計問題樣本中學習,並透過強化學習提升解題效率。此外,人工評估員還會對模型的編碼和問題解決表現進行評分,這種基於人類反饋的強化學習為模型最佳化帶來重要支援。

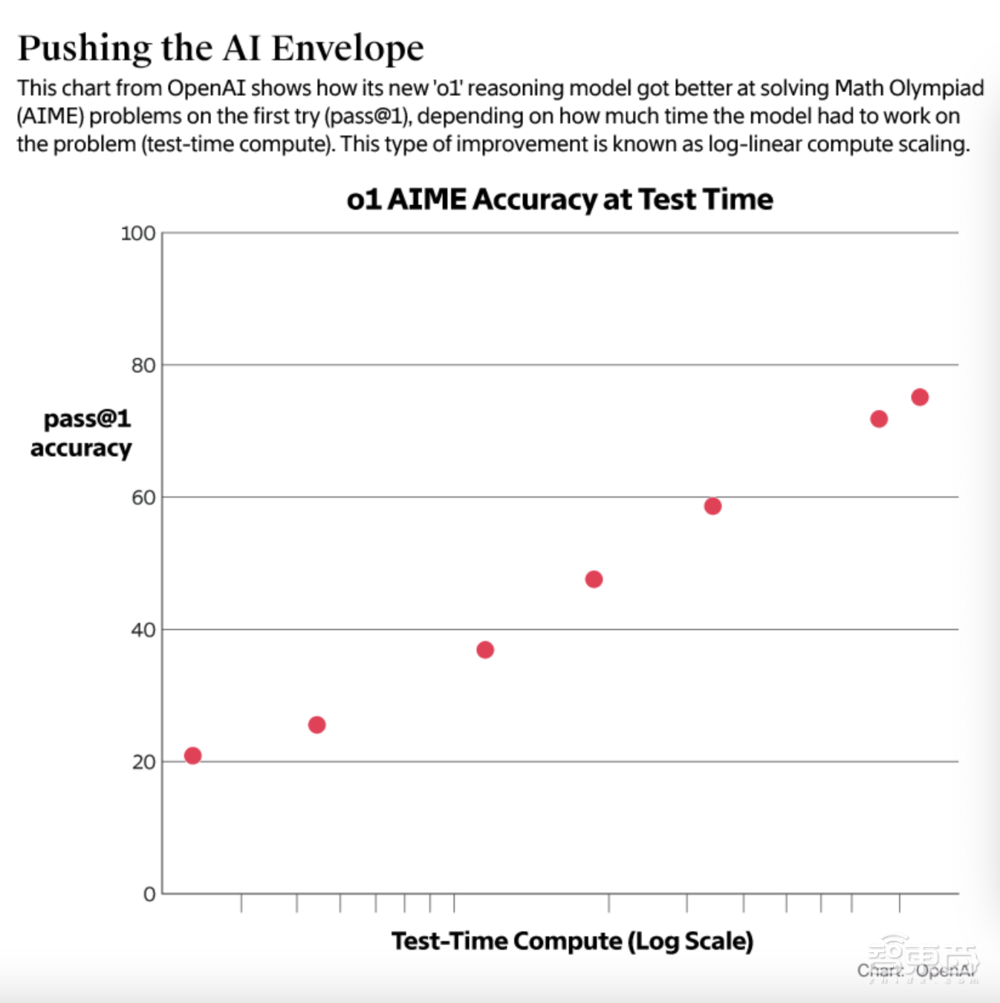

今年9月,OpenAI推出了推理模型o1。與傳統模型不同,o1在回答前“思考”時間更長,透過增加計算資源提升響應質量,顯示出“測試時計算”(Test-Time Compute)的效果。雖然o1的執行成本是普通模型的六倍,並且該模型的客戶群較為有限,但阿爾特曼認為它將為科學研究和複雜程式碼生成等領域帶來突破。

▲OpenAI“ol”推理模型如何更好地解決數學奧林匹克競賽題(圖源:OpenAI)

二、LLM發展平臺期,投資基礎設施效果存疑

據The Information報道,Meta CEO馬克·扎克伯格(Mark Zuckerberg)、阿爾特曼以及其他AI開發公司的執行長均公開講過,當前的技術仍未達到Scaling Law所設定的極限。這或許是包括OpenAI在內的公司,仍在投入數十億美元建設大型資料中心的原因之一,以進一步提升預訓練模型的效能。

然而,OpenAI研究員諾姆·布朗(Noam Brown)在上個月的TEDAI會議上分享說,開發更先進的模型可能在財務上變得不可持續。布朗提出質疑:我們真的要花費數千億美元甚至更多來訓練新的模型嗎?擴充套件的模式終究會達到瓶頸。

OpenAI仍在對其下一代模型Orion進行長時間的安全性測試。據公司員工透露,Orion在明年年初發布時,可能不會沿用傳統的“GPT”命名規則,而是採用新的命名方式。OpenAI官方對此並未做出評論。

一些已經向AI開發商投資了數千萬美元的投資者們,也對LLM是否已經開始趨於穩定表示擔憂。

本·霍洛維茨(Ben Horowitz)是OpenAI的股東之一,同時還投資了Mistral和Safe Superintelligence等競爭對手。他曾談道,OpenAI一直在增加訓練AI所需的GPU數量,但似乎並未獲得預期的智慧改進。不過,他並未進一步詳細說明。霍洛維茨的同事馬克·安德森(Marc Andreessen)談道,許多聰明的研究人員正在努力突破技術瓶頸,嘗試提高推理能力。

企業軟體供應商Databricks的聯合創始人兼董事長Ion Stoica談道,LLM在某些方面可能已經進入瓶頸期,但在其他方面仍在持續進步。Stoica說,他們的平臺允許應用程式開發者評估不同的LLM,並且發現雖然AI在編碼和解決複雜的多步驟問題上持續改進,但在執行一些通用任務(如分析文字情緒或描述醫療症狀)時,能力似乎有所放緩。

Stoica還說,在常識性問題上,LLM的表現可能已經接近極限。為了進一步提升模型的能力,公司需要更多的事實資料,而合成資料的幫助則有限。

結語:強化學習提升模型表現,持續投資保持競爭力

OpenAI正透過多方策略應對當前的技術瓶頸,尤其是在LLM面臨的高質量資料短缺和效能提升困境。為了克服這些挑戰,OpenAI不僅透過強化學習提升模型在數學和程式設計等特定任務中的表現,還依賴於AI資料平臺Scale AI和LLM訓練商Turing等初創公司來管理大量外包承包商,以支援訓練過程。

雖然當前AI基礎設施的投資回報尚不明顯,且在LLM訓練過程中面臨巨大的財務壓力與技術挑戰,但市場競爭與投資熱情尚未減退,競爭者們在持續下注。比如,馬斯克旗下的大模型獨角獸xAI和X平臺及英偉達合作,已建成了10萬片H100 GPU的強大叢集;Meta投入了400億打造類似規模的GPU叢集,以支援Llama 4模型的訓練;蘋果也在積極推進與富士康的合作,提升自家裝置的AI算力。

相關文章

- OpenAI、谷歌、Anthropic新模型遇瓶頸:缺資料、成本高、效能不及預期

- 訊息稱位元組跳動影片生成模型PixelDance即將上線,早於OpenAI的Sora

- 曝OpenAI新旗艦模型“難產”,或明年年初發布

- AMD四款RX 8000M筆記本顯示卡曝光:沒有旗艦、最高功耗175W

- 萬元驍龍8至尊版旗艦!三星Galaxy S25 Ultra外觀曝光

- 谷歌Gemini 2.0 AI模型現蹤跡,響應速度更快

- 60秒生成5秒AI影片,位元組自研影片生成模型Seaweed開放使用

- 三星時隔10年再推超薄旗艦!Galaxy S25 Slim首曝

- 任天堂Switch 2遊戲機模型機曝光:直觀展示8英寸螢幕及磁性Joy-Con手柄

- 因算力瓶頸難產!OpenAI:今年將不會發布GPT-5